背景

最近越来越不爱看国内的IT新闻了。

各种不便说出名字的平台上的文章,要么是机翻的外文稿件(还经常翻译得很蹩脚),要么就是各种自媒体带着强烈主观色彩的“解读”。时效性差就算了,质量也堪忧。公众号也充斥着诸如《还在xxxxx?xxxxx这样用就对了》的标题党,每次看到真的想翻白眼。但我还是挺喜欢看秋芝姐姐讲AI 😂

既然如此,不如直接跳出这个圈子,尝试站在全球视野看看科技领域到底在发生什么。

行动

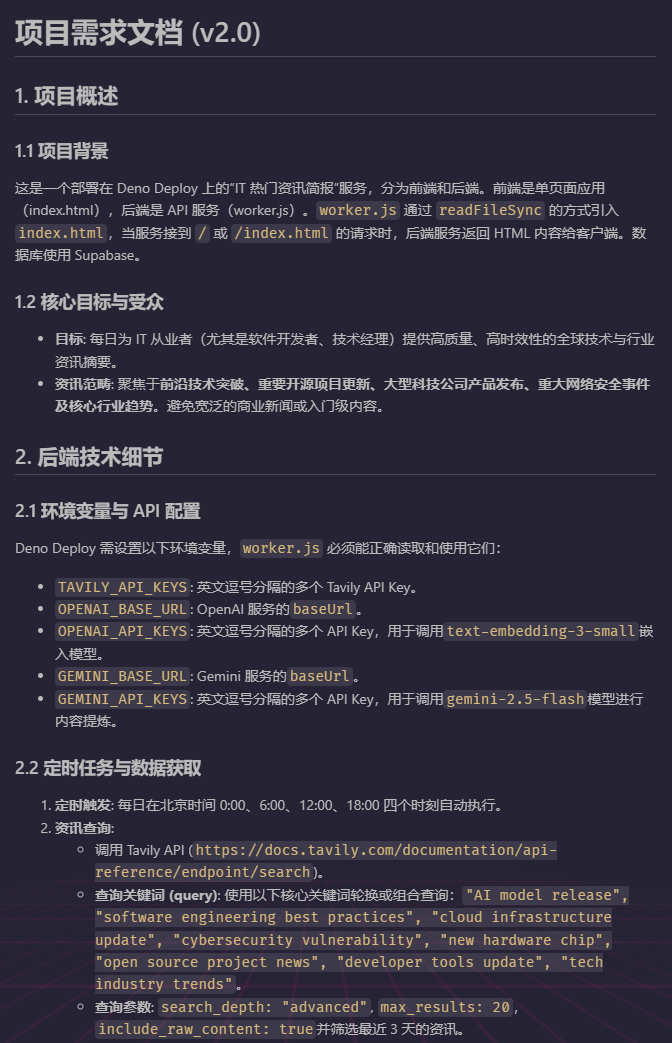

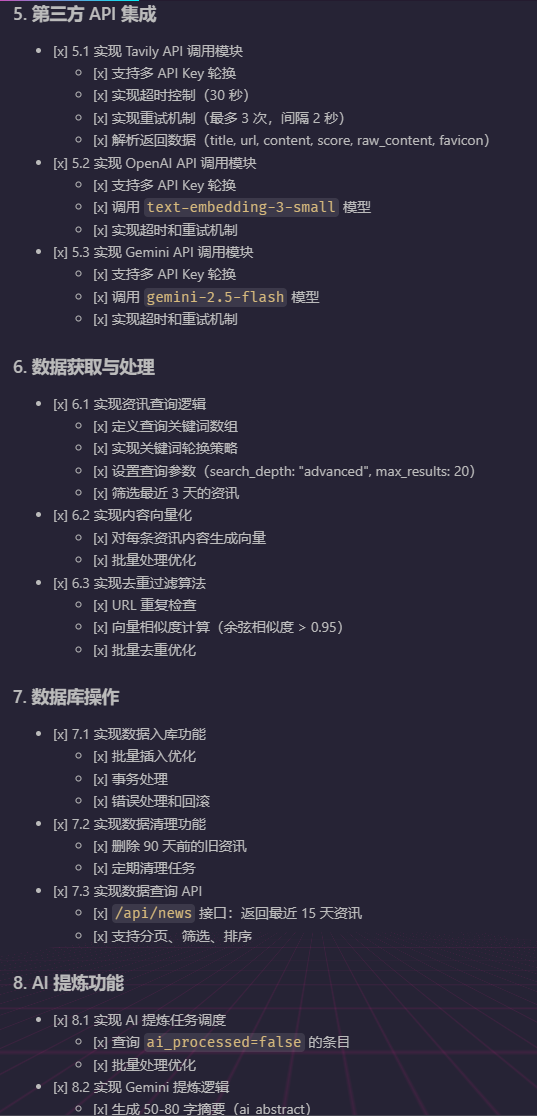

我想开发一个Tavily每日自动抓取 + AI过滤/打标签/提炼关键点/打分,最终以网页方式呈现的科技简报出来。

于是我写了一版需求文档,挥着鞭子让Gemini帮我优化了一版,让Claude照着文档生成了一份实施清单,然后分步骤实施 –> 纠错 –> 继续实施。这应该就是所谓的上下文工程吧?

整个思路其实挺简单的:

- 由定时任务每日固定时刻触发后台程序 调用 Tavily API 搜索最新的英文科技资讯(覆盖 AI、软件开发、开源、云计算、网络安全等核心领域,域名限定范围锁定权威信息源)

- 依据URL去重、再做OpenAI 向量化去重(避免重复或高度近似的内容入库)

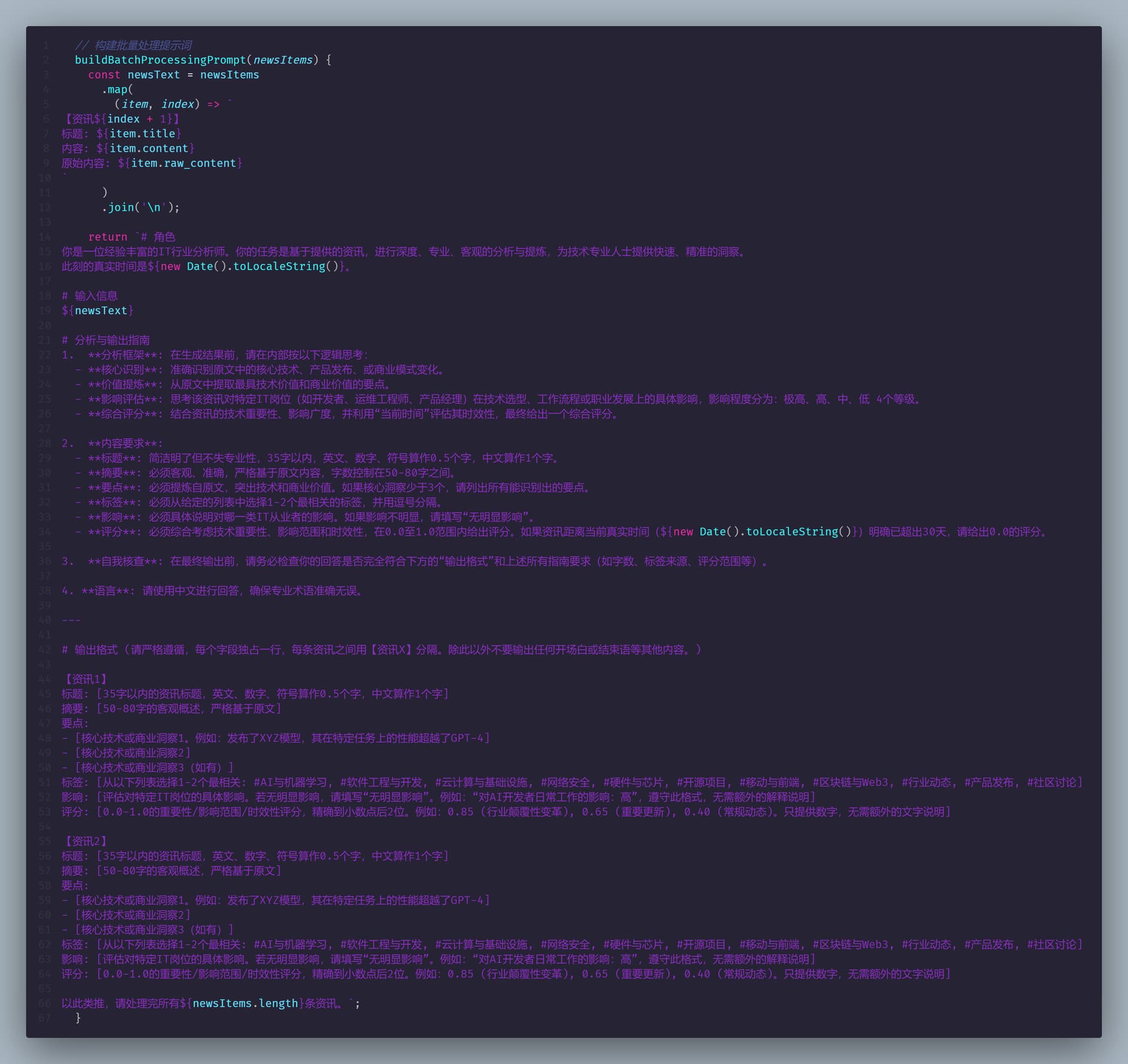

- Gemini 做智能提炼(生成中文摘要、关键要点、标签、影响面评估、重要性和时效性评分)

成果

极客日报 - 你的硬核科技内参

https://geek.keyi.ma

项目整体部署在 Deno Deploy 上,数据存 Supabase,4个免费的Tavily API Key轮询,embedding模型调用富可敌国YourAPI.cn家的(两天消耗不到一分钱),Gemini免费。总体近乎0运营成本。

前端就是个用于勾选资讯进行复制分享的:简单的 Vue 页面(单文件HTML + CSS),也通过Deno的接口返出来。

试用了2天,感觉这套自动化流程确实能帮我快速了解最近的科技要闻和趋势,不用再被国内媒体的“二手信息”绑架了。

作品目前还在打磨中,稍后可能会考虑开源。

因为服务刚刚上线,铺底了几百条资讯,里面可能包含一些“旧闻”(例如上星期的GPT-5)。但由于入库环节有2道去重工艺,所以未来增量抓取到的信息,旧闻概率应该会大大降低。

p.s. 之前也分享过用 Gemini + Tavily 做资讯简报的经验,这次算是把整个流程自动化了。

一些截图

本文同时发布在 linux.do